von Neele Tiedemann

Ein Bericht über das Potenzial von KI für individuelles Schreibfeedback

In den letzten Jahren haben wir beobachtet, dass das akademische Schreiben vielen unserer Studierenden schwer zu fallen scheint. Um sich in diesem Themenbereich zu verbessern, sind Studierende zwingend auf Feedback angewiesen, denn qualitativ hochwertiges Feedback gilt als einer der relevantesten Faktoren zum Lernerfolg (Hattie, 2009). In Forschungsarbeiten konnte bereits nachgewiesen werden, dass das Feedback von Expert:innen verglichen mit Peer-Feedback hochwertiger in den Bereichen Angemessenheit, Fragen und Alternativen ist (Jacobsen & Weber, 2025; Prilop et al., 2021; Weber et al., 2018). In der Hochschule fehlt es aber oftmals an den personellen und finanziellen Ressourcen, um allen Studierenden qualitativ hochwertiges Feedback von Expert:innen zur Verfügung zu stellen (Demszky et al., 2023). KI-Feedback kann diese Lücke möglicherweise schließen. So konnte bereits gezeigt werden, dass Feedback, welches von der KI generiert wurde, signifikant besser als Feedback von Noviz:innen in den Punkten Angemessenheit, Erklärung, Fragen, Nennung und Erklärung von Alternativen, Spezifität und Fehleranzahl ist (Jacobsen & Weber, 2025). In den Punkten Erklärung, Fragen und Spezifität ist das KI-generierte Feedback sogar Expert:innenfeedback überlegen (Jacobsen & Weber, 2025). Somit kann KI-Feedback eine skalierbare, kostengünstige und qualitativ hochwertige Ressource für Feedback in der Hochschule sein (Jacobsen & Weber, 2025). Dabei ist jedoch zu beachten, dass adäquate Prompts fachkundig geschrieben werden und unter menschlicher Aufsicht getestet und bei Bedarf überarbeitet werden (Jacobsen & Weber, 2025). Genau hierfür ist Expert:innenwissen wichtig (Jacobsen & Weber, 2025). Diese wissenschaftlichen Erkenntnisse machten wir uns basierend auf unserer zu Beginn angeführten Beobachtung zunutze:

Im Wintersemester 2024/2025 verantwortete unsere Professur das Modul Schulpädagogik, welches ein verpflichtendes Modul aller Studierenden des Bachelorstudiengangs Lehren und Lernen ist. Das Modul besteht aus einer Vorlesung und einem Seminar. Desweiteren kann freiwillig ein Tutorium besucht werden. Die Prüfungsleistung umfasst das Ablegen eines Test zu Vorlesung, sowie das Verfassen eines Essays im Rahmen des Seminars. Das Essay wird von den Seminaren verantwortet, welche alle eine unterschiedliche, thematische Schwerpunktsetzung haben. Im Rahmenstudienplan ist unser Modul im 5. Bachelorsemester angelegt, worauf im sechsten Semester unter anderem die Bachelorarbeit folgt. Daher ist davon auszugehen, dass die Studierenden alle in naher Zukunft ihre Bachelorarbeit schreiben werden. Aus unserer Sicht war es somit ein guter Zeitpunkt, zu welchem Studierende noch einmal Feedback auf ihr akademisches Schreiben erhalten sollten, um dies auch in ihren weiteren schriftlichen, wissenschaftlichen Arbeiten umsetzen zu können. Da die Seminare inhaltlich sehr unterschiedlich sind und somit auch die von den Studierenden geschriebenen Essays unterschiedliche Themen behandeln, haben wir uns dazu entschieden, ihnen ausschließlich auf rein struktureller Ebene Feedback zu geben. Dazu haben die Punkte Deckblatt, Layout, Strukturierung des Textes, Zitation, Essayumfang sowie Sprache und Stil gezählt. Als Grundlage für den Prompt galt unser Erwartungshorizont. Unseren Prompt haben wir mehrfach mit ChatGPT 4 getestet und überarbeitet. Den finalen Prompt haben wir in Absprache mit dem Datenschutz und dem Prüfungsamt den Studierenden zur Verfügung gestellt. Als weitere Hinweise haben sie erhalten, dass der Prompt für ChatGPT 4 entwickelt wurde, es keine Garantie dafür gibt, dass die Dozierenden als prüfende Personen mit dem KI-Feedback übereinstimmen und dass die Nutzung von ChatGPT über die AcademicCloud aufgrund des Datenschutzes empfohlen wird. Die Studierenden konnten sich das Feedback dann selbstständig und auf freiwilliger Basis von einer Künstlichen Intelligenz generieren lassen. Künstliche Intelligenz haben wir für die Prüfung offiziell unbeschränkt als Hilfsmittel erlaubt.

Wir haben den Studierenden zu Evaluationszwecken einen Link zu einer LimeSurvey-Umfrage zugesendet, die sie freiwillig und anonym ausfüllen konnten. Der Fragebogen bestand aus 8 Itemgruppen: Prompt-Nutzung, Feedback Perception nach Strijbos, Narciss & Dünnebier (2010), Gründe für die Nicht-Nutzung, Organisatorisches, Feedbackquellen für das Essay, Feedbackgelegenheiten im Studium, Nutzungsverhalten von KI und soziodemographische Daten.

Abbildung 1: Aufbau des Fragebogens

Es haben 26 der 192 Studierenden die Umfrage vollständig ausgefüllt, dies entspricht knapp 14%. Die Ergebnisse und unsere Erkenntnisse daraus sollen hier kurz vorgestellt werden:

Von den Umfrageteilnehmenden haben 59% unseren Prompt genutzt. Gemäß der Feedback Perceptions nach Strijbos, Narciss & Dünnebier (2010) wurde das KI-generierte Feedback als eher fair und nützlich wahrgenommen, sodass die Bereitwilligkeit zur Umsetzung des Feedbacks seitens der Studierenden vorhanden war. Das Feedback wurde weiterhin eher mit positiven als mit negativen Affekten verbunden. Als besonders fair wurde im Freitextfeld hervorgehoben, dass das Feedback ehrlich, kurz und knapp war, gleichzeitig positive Aspekte nannte und detaillierte Tipps zur Verbesserung aufwarf. Das Feedback wurde als konstruktiv für die strukturelle Gestalt des akademischen Schreibens wahrgenommen und es konnte auch eine Vergewisserung stattfinden, indem positive Punkte genannt wurden. Allerdings wurde darauf hingewiesen, dass das KI-Feedback teilweise Aspekte kritisierte, die von den Studierenden selbst sowie von ihren Peers als positiv bewertet wurden. Zudem zeigte die KI bei Rückfragen häufig unkonkretes oder unspezifisches Feedback. Letzteres wurde von einer Person auch als frustrierend beschrieben. Eine Person hat außerdem festgestellt, dass ihre eigenen mangelnden Fähigkeiten, Prompts und Nachfragen zu formulieren, sich frustrierend angefühlt haben.

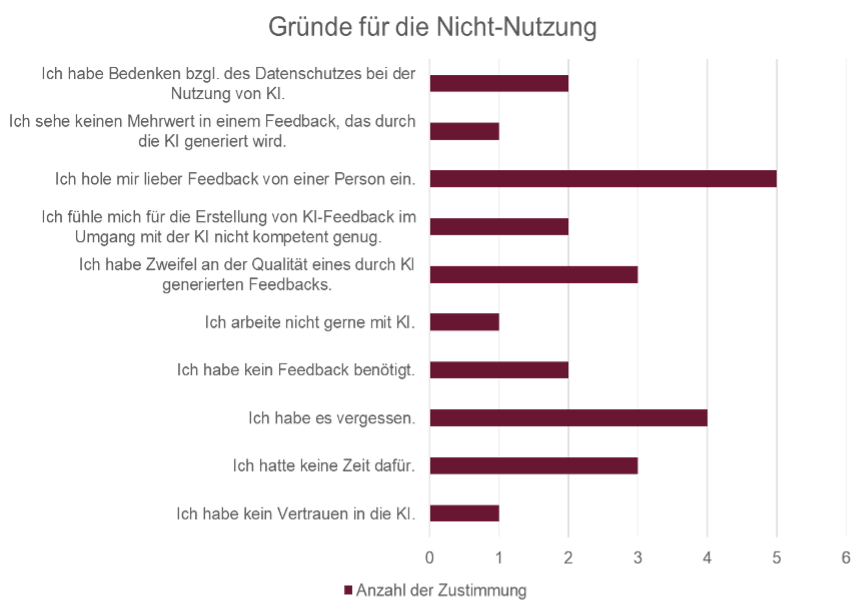

6 Studierende, die den Prompt nicht genutzt haben, gaben an, dass sie sich lieber Feedback von einer Person einholen. Damit stellt dieser Punkt den am häufigsten genannten Grund dar. Weiterhin haben 4 Personen angegeben, dass sie es schlicht weg vergessen haben, 3 Studierenden zweifeln an der Qualität eines KI-Feedbacks oder hatten keine Zeit für die Generierung eines KI-Feedbacks. Weitere Gründe können in Abbildung 2 erkannt werden.

Abbildung 2: Gründe für die Nicht-Nutzung des Prompts für die Erstellung von KI-Feedback, Mehrfachantwort möglich

Von unseren Studierenden haben sich knapp 25% nicht gut über das KI-Feedback und das Vorgehen informiert gefühlt, außerdem berichten 4 von 23 Personen von technischen Problemen bei der Erstellung.

Bei der Abfrage der wahrgenommenen Sicherheit im Umgang mit Künstlicher Intelligenz gab eine Person an, dass sie sich unsicher fühlt, 2 fühlen sich eher unsicher. 7 Studierende berichten über eine durchschnittliche Sicherheit, während 13 sich eher sicher und 3 sich sicher fühlen. Im universitären Kontext geben 17 Studierende an, dass sie KI wöchentlich nutzen, 3 Personen sogar täglich. 5 Personen geben an, dass sie KI monatlich nutzen. Nur eine Person nutzt KI im universitären Kontext nie.

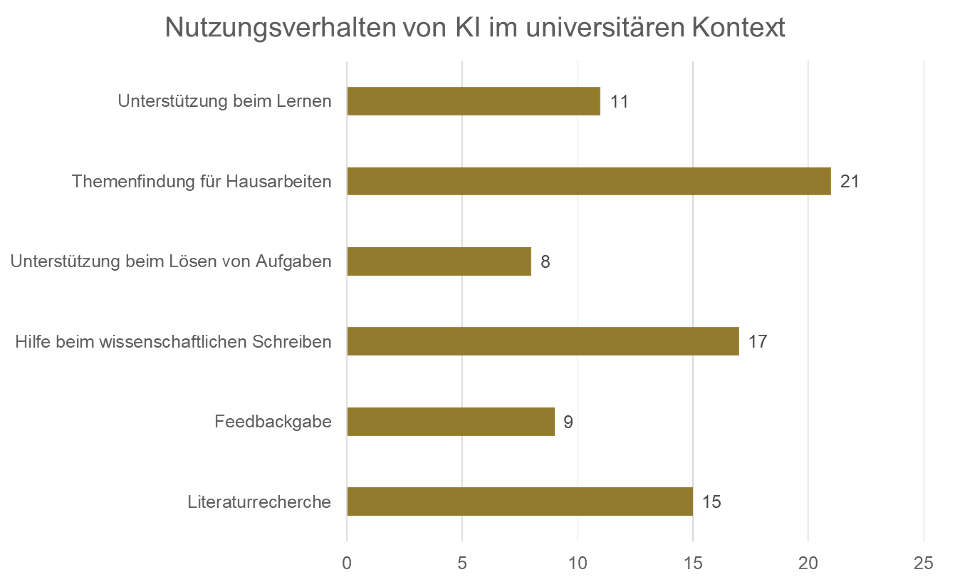

Bei der Frage, wofür unsere Studierende KI in der Universität nutzen, gaben 21 Personen an, dass KI ihnen bei der Themenfindung für Hausarbeiten unterstützt. 17 Personen nutzen die KI als Hilfe beim wissenschaftlichen Schreiben. Weitere Nutzungen können Abbildung 3 entnommen werden.

Abbildung 3: Nutzungsverhalten von KI im universitären Kontext, Mehrfachantwort möglich

Abschließend wurde von Seiten der Studierenden zum einen der Wunsch geäußert, eine umfangreichere Einführung in das Themenfeld KI und KI-Feedback in der Veranstaltung zu erhalten. Außerdem wurde deutlich, dass sich die Studierenden auf unterschiedlichen Wissensständen zur Thematik KI befinden. Es wird sich gewünscht, dass alle Studierenden von ihrem Kenntnisstand aus abgeholt werden. Beispielhaft werden kurze Inputs, Informationsseiten oder Informationsdokumente vorgeschlagen.

Trotz der geringen Anzahl von 26 Teilnehmenden an unserer Umfrage konnten wir für unsere weitere Arbeit wichtige Erkenntnisse mitnehmen. So haben wir zunächst festgehalten, dass ein Teil der Studierenden Interesse an KI-generiertem Feedback hat und unseren geschriebenen Prompt auch genutzt haben. Die Personen, die KI-generiertes Feedback genutzt haben, nahmen das Feedback eher positiv wahr und schätzten die Möglichkeit.

Das Problem, dass das Feedback den Studierenden zum Teil eher unkonkret vorkam, kann mit einem weiter überarbeiteten Prompt gelöst werden. Es bleibt jedoch weiterhin ein Problem, dass wir nicht wissen, wie die Studierenden mit der KI gearbeitet und welches Modell sie genutzt haben, sodass wir nur die Stellschraube des Prompts beeinflussen können. Die Qualität des Feedbacks aber zu einem großen Teil von den Studierenden mitverantwortet werden, weil sie mit der KI interagieren. Aus rechtlicher Sicht können wir uns nicht als qualitätsprüfende Instanz mittels Tutor:innen zwischenstellen.

Daher bietet sich hier der – auch von Studierenden genannte – Ansatzpunkt an, dass Studierende im Rahmen ihres Studiums mehr über KI und die gute Nutzung von KI lernen sollten. Dafür sollten sich auch modul- und studiengangsübergreifend Formate überlegt werden, die Studierende mit den nötigen KI-Kompetenzen ausstatten. Wir bemühen uns, unseren Studierenden im Rahmen unseres Tutoriums weitere Informationen zum Themenbereich Künstliche Intelligenz anzubieten, indem wir in einzelnen Sitzungen über das Thema KI sprechen und die Arbeit mit dieser reflektieren.

Literatur

Demszky, D., Liu, J., Hill, H. C., Jurafsky, D., & Piech, C. (2023). Can Automated Feedback Improve Teachers’ Uptake of Student Ideas? Evidence From a Randomized Controlles Trial in a Large-Scale Online Course. Educational Evaluation and Policy Analysis, 46(3), 483–505. https://doi.org/10.3102/01623737231169270

Hattie, J. (2009). Visible Learning. A sythesis of over 800 metaanalyses relating to achievement. Routledge.

Jacobsen, L. J., & Weber, K. E. (2025). The Promises and Pitfalls of LLMs as Feedback Providers: A Study of Prompt Engineering and the Quality of AI-Driven Feedback. AI, 6(2), 35. https://doi.org/10.3390/ai6020035

Prilop, C. N., Weber, K. E., & Kleinknecht, M. (2021). The role of expert feedback in the development of pre-service teachers’ professional vision of classroom management in an online blended learning environment. Teaching and Teacher Education, 99. https://doi.org/10.1016/j.tate.2020.103276

Strijbos, J.-W., Narciss, S., & Dünnebier, K. (2010). Peer feedback content and sender’s competence level in academic writing revision tasks: Are they critical for feedback perceptions and efficiency? Learning and Instruction, 20, 291–303. https://doi.org/10.1016/j.learninstruc.2009.08.008

Weber, K. E., Gold, B., Prilop, C. N., & Kleinknecht, M. (2018). Promoting pre-service teachers’ professional vision of classroom management during practical school training: Effects of a structured online- and video-based self-reflection and feedback intervention. Teaching and Teacher Education, 76, 39–49. https://doi.org/10.1016/j.tate.2018.08.008